Přestože v posledních dekádách zaznamenáváme významný rozvoj autonomních strojů a umělé inteligence, nikdo ve skutečnosti neví, jak nejpokročilejší algoritmy umělé inteligence fungují a co dělají. To může být problém, píše Will Knight ve článku The Dark Secret at the Heart of AI, který vám nyní volně zprostředkujeme.

Autor začíná svůj článek zmínkou o vozidle, které bylo v loňském roce v tichosti vypuštěné do provozu v Monmouth County v New Jersey. Jednalo se o autonomní automobil společnosti Nvidia, řízený algoritmy, které nevytvořil programátor – program se ho naučil sám sledováním, jak řídí lidé.

Informace ze senzorů vozidlo zpracovává do ohromné sítě umělých neuronů a výsledkem jsou rozhodnutí o dané situaci. Když však dojde k nehodě, může být velice složité odhalit, kde se stala chyba, a to dokonce pro ty, kteří původní program vytvářeli. Neexistuje totiž žádný jasný postup, jak takový systém vytvářet, takže není vždy možné vysvětlit, proč a co program udělal. Umělá inteligence autonomních vozidel je součástí dnes již existujícího a stále se rozšiřujícího prostředí, v němž stroje dokáží rozpoznávat obrázky, číst texty a překládat je – například právě v těchto dnech Google představil skokové vylepšení svého překladače. Ten se nyní učí napříč všemi jazyky, vyhledává mezi nimi podobnosti a v mnoha případech je schopen překládat až s neuvěřitelnou přesností a s citem pro zdrojový i cílový jazyk.

Ne nadarmo se stále častěji mluví o další technologické revoluci, která za sebou zanechá miliony nezaměstnaných v terciárním sektoru. Je tak třeba začít uvažovat o způsobech, jak se s toto proměnou pracovního trhu vyrovnat, ať už vyšším zdaněním robotizované práce, nebo zavedením tzv. univerzálního příjmu. Práce (téměř) pro každého totiž už nejen dle pesimistických předpovědí nebude. Pochmurná predikce začíná být rysem realistického uvažování.

Hluboké učení, černá skříňka

Doposud nejrůznější instituce – bankovní, pojišťovny, zdravotní, vojenské aj. – využívaly matematických modelů a propočtů, aby dokázaly určit, komu je např. možné svěřit úvěr, jaké pojištění lze nabídnout. Nyní však začíná docházet v těchto oblastech k další automatizaci – stroje se dokáží učit a v komplexních situacích přinášet vlastní rozhodnutí. Nejčastějšímu z těchto přístupů se říká hluboké učení. To představuje fundamentálně nové způsoby programování počítačových programů. Můžeme však přistoupit na to, že tato rozhodnutí vychází z černé skříňky, o jejímž fungování vlastně víme velmi málo, nebo by měla být možnost stopovat systémy umělé inteligence tak, abychom věděli, jak dospěly k určitým rozhodnutím, základním právem?

K tomuto uveďme, že evropské právo počítá s tím, že od roku 2018 by lidé měli mít přístup ke zdůvodnění automatizovaných rozhodnutí, která o nich učiní systémy UI těch společností, které jich budou využívat. V jaké podobě bychom mohli tato zdůvodnění dostávat, se můžeme jen domnívat, když samotní tvůrci systémů automatického učení často nedokáží vysvětlit, jakým způsobem funguje například zdánlivě jednoduché cílení reklamy na webu nebo automatický výběr hudby.

Problém spočívá v tom, že ačkoliv nerozumíme ani vlastnímu vědomí a některá rozhodnutí činíme na základě nevysvětlitelných emocí, mezi lidmi existuje intuitivní důvěra. Dokážeme tuto důvěru přenést i na stroje? Jedná se o novou situaci, jelikož nikdy předtím jsme nevytvořili stroje, které fungují způsoby, kterým nerozumí ani jejich tvůrci a které jsou nepředvídatelné. Navíc, při učení stroje mohou přebírat naše vlastní předsudky a bez nějakých morálních pojistek činit zaujatá rozhodnutí.

Stroje a rasové a genderové předsudky

Zajímavou lekci nám může dát automatizované učení strojů v oblasti studia jazykových stereotypů. Ve článku AI programs exhibit racial and gender biases, research reveals jeho autorka Hannah Devlin mluví o rozšiřování spektra existujících sociálních nerovností a předsudků prostřednictvím nepředvídatelných rozhodnutí, která činí automaty. K tomu dochází například v případě zmíněného překladače společnosti Google. K jeho zlepšení totiž přispěla dostupnost nezměrného objemu online textových dat, na kterých se mohou jeho algoritmy vycvičit. Tím, jak stroje dosahují stále více lidských jazykových schopností, absorbují zároveň hluboce zakořeněné předsudky ukryté v rámci jazykových modelů.

Podle studie vědců z University of Bath předsudky UI ukazují, že jsme to my, kdo je předsudečný, a dále to UI učíme. Joanna Bryson, jedna z autorek studie, k tomu však uvádí, že UI má na rozdíl od lidí potenciál tyto předsudky posílit, protože její algoritmy nejsou vybaveny k tomu vědomě klást odpor naučeným předsudkům. Nebezpečím tak může být systém UI postrádající explicitní část, která je řízena morálními idejemi.

Studie publikovaná ve článku Semantics derived automatically from language corpora contain human-like biases v časopise Science se zaměřuje na strojové učení známé jako „word embedding“, které transformuje způsob, jakým počítače interpretují řeč a text. Tento přístup vytváří matematickou reprezentaci jazyka, v níž je význam slova převeden do řady čísel založené na tom, která jiná slova jsou nejčastěji v souvislosti s tímto slovem používána.

Možná je překvapující, že tento čistě statistický přístup zachycuje bohatý kulturní a sociální kontext významu slova způsobem, jakým by to nedokázala ani slovníková definice. Matematicky jsou si tak blíže slova jako květiny a příjemnost, zatímco hmyz je blíže slovu nepříjemnost. To přináší potíže v tom, že například slova ženský a žena najdeme propojená více s humanitními povoláními a domovem, zatímco slova mužský a muž blíže technickým profesím; evropská jména jsou spojená se slovy jako dárek nebo šťastný, zatímco afroamerická jména pak častěji spojená s nepříjemnými slovy. Vzpomeňme si přitom na studie, které ukázaly důležitost jména či pohlaví v životopise a dohlédněme důsledky automatizovaného rozhodování strojů ve stále více oblastech našeho každodenního života.

Není to nejspíš nic překvapivého. Pokud žijeme ve světě, který je předsudečný, a historická data jsou také předsudečná, dostaneme potom předsudečné výsledky. Velkou výzvou pro UI je tedy budoucí schopnost eliminovat nevhodné zaujetí z algoritmů vytvořených k porozumění jazyku, aniž bychom ztratili jejich sílu interpretace. Podle některých výzkumníků je tak potřeba hlídací pes, který by dokázal regulovat automatizovaná rozhodnutí strojů.

Mají skvělé výsledky, ale nevíme, jak k nim došly

Využití UI může však stále přinášet dobré výsledky. Například v roce 2015 v newyorské nemocnici Mount Sinai Hospital aplikovali hluboké učení na rozsáhlou databázi pacientů. Kombinací stovek proměnných založených na výsledcích zdravotních prohlídek a testů, program s názvem Deep Patient prokázal neuvěřitelnou spolehlivost v předpovídání nemocí. Aniž by dostal instrukce od experta, dokázal odhalit vzorec skrytý v nemocničních datech, která indikovala, kdy lidé onemocní, například rakovinou jater. Zároveň je však na programu Deep Patient něco záhadného.

Zdá se, že algoritmus dokázal dobře odhalit psychické poruchy jako je schizofrenie, což je v lékařské praxi velmi obtížné. Nad výsledkem žasl i doktor Joel Dudley, který vede tým ve zmíněné nemocnici a který doposud neví, jak je taková indikace možná. Nový nástroj totiž neposkytuje žádné vodítko, jak svého výsledku dosáhl. Pokud tak něco jako Deep Patient skutečně pomůže doktorům, může doplnit jejich léčbu a poskytnout jim ospravedlnění zvolených postupů, doktoři však nezjistí, jak modely, na které se spolehnou, fungují.

Dvě cesty

Umělá inteligence však nebyla vždy taková. Původně existovaly dva myšlenkové proudy, dvě školy, které určovaly, jak srozumitelná nebo vysvětlitelná by měla UI být. Mnoho lidí si myslelo, že dává smysl, aby se stroje řídily pravidly a logikou a své postupy činily transparentní komukoliv, kdo nahlédne do jejich kódu.

Jiní měli představu, že inteligence by se měla snáze rozvinout, pokud by stroje čerpaly inspiraci z biologie a učily se pozorováním a zkušeností. To znamenalo obrátit počítačové programování na hlavu – místo, aby programátor psal příkazy k vyřešení problému, program generuje svůj vlastní algoritmus založený na vzorových příkladech a požadovaném výstupu. Strojové techniky učení se později rozvinuly v nejsilnější systémy UI následováním této druhé cesty. Stroje programují samy sebe.

Tento přístup byl poměrně dlouhá léta limitován, zájem o něj obnovily až komputerizace a přístup k rozsáhlým datovým souborům. Postupně se pak rozvinul až do podoby umělé neuronové sítě, takže v 90. letech neuronové sítě dokáží digitalizovat ručně psané znaky. Až začátkem této dekády však můžeme začít mluvit o skutečně dramatickém zlepšení v automatizovaném rozpoznávání a právě hluboké učení stojí za dnešní explozí UI, symbolizované například spolehlivým rozpoznáním mluveného slova. Její využití, jak bylo řečeno výše, je dnes ovšem stále širší a všudypřítomnější.

No dobře, ale nějak to přeci funguje, ne?

Když jsme zmínili hluboké učení jako černou skříňku, o jejíchž vnitřních procesech nemáme dostatečný přehled, neznamená to, že všechny budoucí techniky UI budou stejně tajemné a nepochopitelné. Není možné se podívat do vnitřku neuronové sítě, abychom viděli, jak funguje. Úvaha neuronové sítě je zakotvena v chování tisíců simulovaných neuronů uspořádaných do desítek nebo stovek složitě propojených vrstev.

Neurony v první vrstvě obdrží vstup, jako je intenzita pixelu na obrázku, a provedou výpočet před odesláním nového signálu. Tyto výstupy jsou přiváděny ve složité pavučině neuronům v další vrstvě a tak dále, dokud není vyprodukován celkový výstup. Navíc existuje proces známý jako „zpětné šíření“ [angl. back-propagation], který vykresluje výpočty jednotlivých neuronů tak, aby se síť naučila produkovat požadovaný výstup.

Mnoho vrstev hluboké sítě umožňuje rozpoznávat věci na různých úrovních abstrakce. V systému určeném k rozpoznání psů například dolní vrstvy rozpoznávají jednoduché věci, jako jsou obrysy nebo barvy, vyšší vrstvy rozpoznávají složitější věci jako srst nebo oči a nejvyšší vrstva vše identifikuje jako psa. Stejný přístup lze použít u jiných vstupů, které vedou stroj k tomu, aby se sám učil: zvuky, které tvoří slova v řeči, písmena a slova, která vytvářejí věty v textu, nebo pohyby volantu, které jsou potřebné pro řízení.

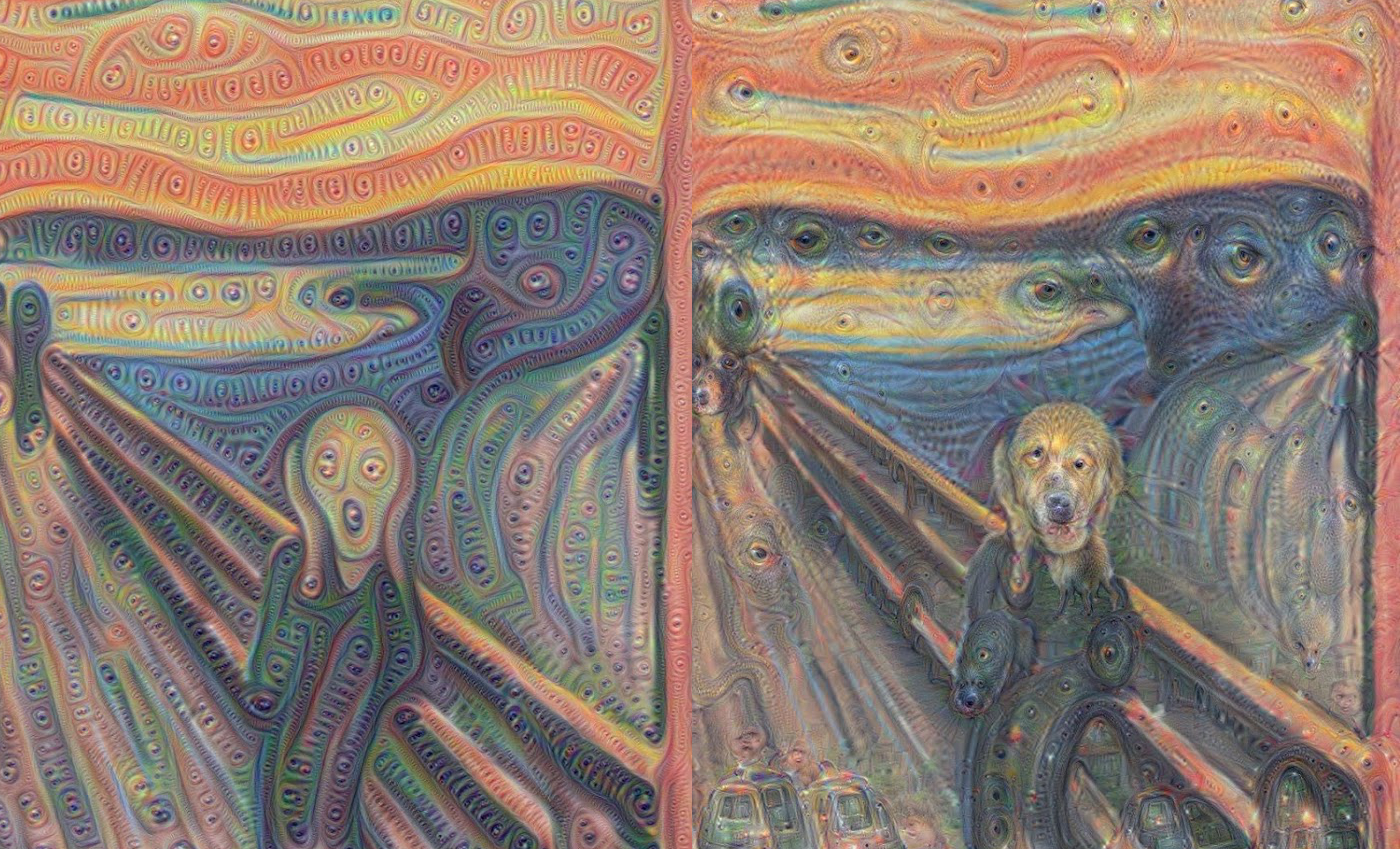

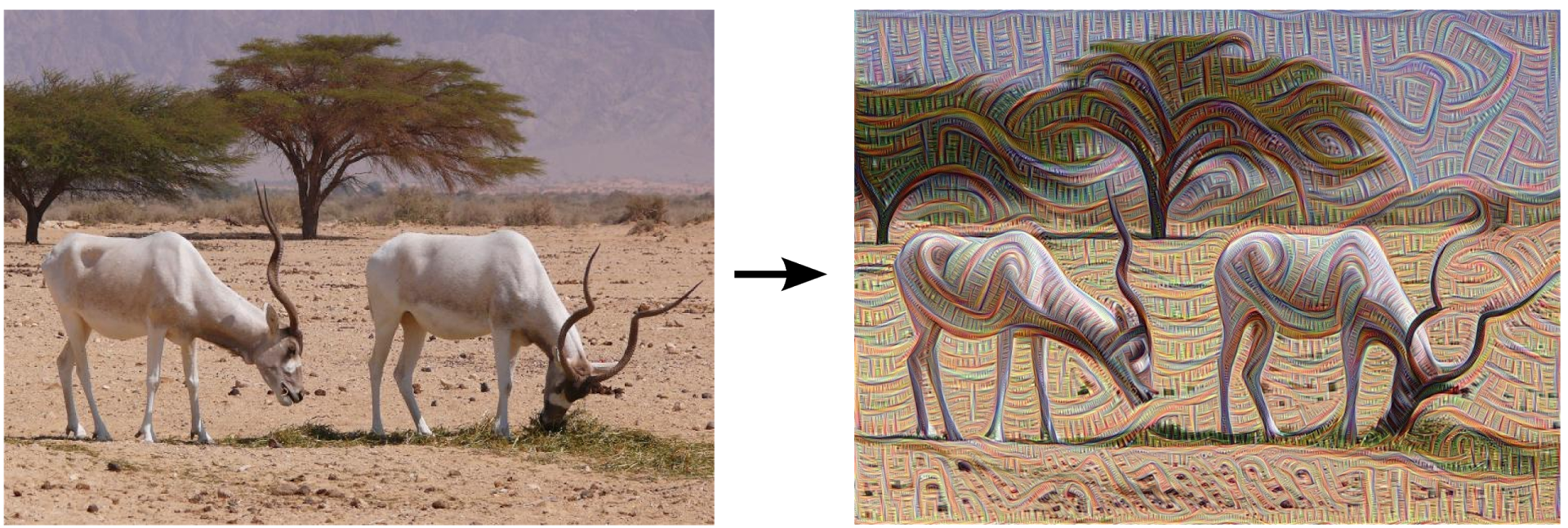

Není to tedy tak, že by neexistovaly strategie, jak podrobněji vysvětlit, co se v systémech UI děje. Např. v roce 2015 výzkumníci společnosti Google upravili algoritmus rozpoznání obrazu tak, aby místo objevování objektů v obrazu tyto objekty generoval nebo upravoval. Zpětným chodem algoritmu dokázali objevit funkce, které program používá k rozpoznávání, např. ptáka nebo budovy. Výsledné snímky, vytvořené v projektu známém jako Deep Dream, ukázaly směšná, mimozemská zvířata vyrůstající z mraků a rostlin a halucinační pagody rozkvétající přes lesy a pohoří. Tím výzkumníci ukázali, že hluboké učení nemusí být úplně nevyzpytatelné. Algoritmy se zaměřují na povědomé vizuální rysy, jako je zobák ptáka nebo peří. Obrazy ale také naznačovaly, jak odlišné je hluboké učení od lidského vnímání, tím, že může vytvořit něco z artefaktu, který bychom my lidé ignorovali. Když tak algoritmus generoval obraz činky, generoval také lidskou ruku, která ji drží – dospěl totiž k závěru, že součástí věci je i ruka.

Limity vysvětlení jsme také my

K pochopení UI potřebujeme tedy více, než jen pohled na její myšlení. Pokud bychom podle Tommiho Jaakkoly, výzkumníka z Massachusetts Institute of Technology v Bostonu, měli velmi malou neuronovou síť, měli bychom být schopni ji pochopit, v případě velkých sítí o tisících jednotkách na vrstvu a při stovkách vrstev se pochopení stává nemožným. Jaakolova kolegyně Regina Barzilay, které byla před pár lety diagnostikována rakovina prsu, mluví o obrovském potenciálu k revoluci v medicíně při využití metod statistického a strojového učení. Uvědomuje si přitom, že to bude znamenat překročení hranic lékařských záznamů, a to využitím surových dat, která nejsou doposud využívána, jako jsou obrazová data nebo patologické údaje.

Barzilay spolu se svými studenty začala spolupracovat s nemocnicí v Massachusetts, aby společně vyvinuli systém schopný dolovat patologické zprávy s cílem identifikovat pacienty se specifickými klinickými znaky, které by výzkumníci mohli chtít studovat. Aby systém mohl vysvětlit své uvažování, Barzilay přidala další krok. Systém extrahuje a zdůrazňuje úryvky textu, které reprezentují vzorek, který program objevil. Dále vyvíjejí algoritmus hlubokého učení, který je schopen najít známky rakoviny prsu na mamografických snímcích, a snaží se tomuto systému dát schopnost vysvětlit své argumenty.

Podobně americká armáda investuje ohromné sumy do vývoje hlubokého učení. Ve vojenské oblasti je přitom ze zřejmých důvodů vysvětlitelnost klíčovým parametrem a pro algoritmické tajemství existuje jen málo prostoru, o čemž svědčí např. zřízení úřadu Explainable Artificial Intelligence.

Nevýhoda vyvíjených přístupů však spočívá v tom, že podané vysvětlení bude vždy určitým způsobem zjednodušené a některé informace se tím pádem po cestě ztratí. Výzkumníci tudíž přiznávají, že jsou ještě daleko od skutečně interpretovatelné UI. Znalost argumentů UI je přitom zásadní, pokud se tato technologie stává běžnou součástí našeho každodenního života, jako je třeba situace, při které nám mobilní aplikace doporučuje restauraci. I v tomto případě chceme, aby vám program dokázal vysvětlit, proč máte zvolit právě daný podnik. Vysvětlitelnost je tak stále více považována za jádro rozvíjejícího se vztahu mezi člověkem a inteligentními stroji.

Tak jako ale neumíme vysvětlit detailně mnoho aspektů lidského chování, pravděpodobně nebudeme nikdy schopni vysvětlit vše, co dělá UI. Jen část inteligence by tak mohla být racionálně vysvětlena a zbytek považován za instinktivní, podvědomý, nevyzpytatelný, což si vyžádá určitý vklad důvěry v inteligentní stroje. Nejspíš bude také třeba do UI zahrnout sociální inteligenci a zmíněnou morální pojistku – tak jako je společnost postavena na smlouvě předpokládaného jednání, také inteligentní stroje by měly být vytvářeny tak, aby respektovaly a vyhovovaly našim sociálním normám. To se týká nejen automatických strojů na zabíjení; stroje musí být vždy schopny rozhodovat v souladu s našimi etickými úsudky.

Filozof a kognitivní vědec Daniel Dennett z Tufts University, autor knihy From Bacteria to Bach and Back, k tomu říká, že přirozenou součástí evoluce inteligence jako takové je vytvoření systémů schopných plnit úkoly, u kterých jejich tvůrci neví, jak na ně. Otázkou je, jaké standarty máme požadovat od nich a od nás samotných. Rovněž se dotýká problému vysvětlitelnosti. Podle něj je jasné, že pokud budeme používat inteligentní stroje a spoléhat se na ně, budeme vyžadovat, aby nám podaly co nejlepší vysvětlení. Jenže v mnoha případech neexistuje perfektní odpověď, měli bychom tak být opatrní ve čtení odpovědí tak, jako to děláme mezi sebou: „Pokud stroj nedokáže poskytnout lepší vysvětlení toho, co dělá, než my, pak mu nevěřme,“ dodává Dennett.

Zvládneme to?

S velkou pravděpodobností se s novou situací dokážeme vyrovnat. Do určité míry se totiž pohybujeme na poli pro sociology poměrně známém – když Anthony Giddens mluví o důvěře, neopomíjí důvěru v expertní systémy, ale i předměty běžné každodenní zkušenosti, jako jsou např. schody v budově, do které potřebujeme vstoupit. Lze tedy předpokládat, že podobným způsobem dokážeme přistoupit k inteligentním strojům, robotům a černým skříňkám UI, protože už dnes svoji důvěru v materiální svět vkládáme.

Mnohem palčivějším problémem tak zůstanou proměny na trhu práce, o kterých slýcháme stále častěji. Velký úkol nespočívá jen na bedrech výzkumníků mapujících fungování UI, ale na bedrech politických reprezentací a všech aktérů, kteří mají zásadní vliv na organizaci práce a veřejných a sociálních systémů. Nepřipravíme-li se totiž na tyto změny, nebude cesta do hlubin robotovy duše nejspíš nikoho zajímat.

Odkazy

Knight, Will. 2017. „The Dark Secret at the Heart of AI.“ In: MIT Technology Review, 11. 4. 2017. <technologyreview.com/s/604087/the-dark-secret-at-the-heart-of-ai/>

Devlin, Hannah. 2017. „AI programs exhibit racial and gender biases, research reveals.“ In: The Guardian, 13. 4. 2017 <theguardian.com/technology/2017/apr/13/ai-programs-exhibit-racist-and-sexist-biases-research-reveals>

Zdroj ilustrací: Inceptionism: Going deeper into Neural Networks.